从传感器到算法:手机摄像头芯片发展脉络深度揭秘

- 问答

- 2025-11-02 20:44:13

- 1

(信息主要综合自半导体行业观察、电子工程专辑、各芯片厂商白皮书及行业分析师报告)

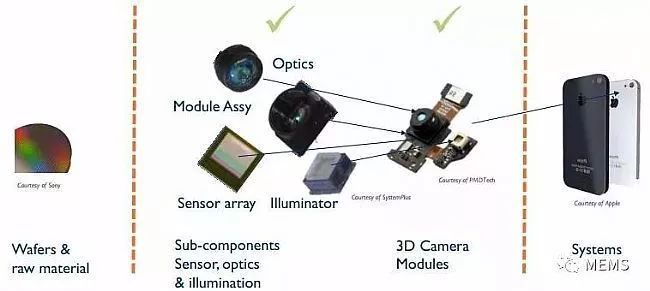

一开始,手机能拍照就是个了不起的进步,最早的手机摄像头芯片,就像给手机装了个“电子眼”,但这只眼睛看东西很模糊,那时候的传感器(CMOS图像传感器)只管把看到的光线转换成电信号,非常初级,手机处理器(SoC)里有一个小部分叫ISP(图像信号处理器),它的任务就是把这些杂乱的电信号“翻译”成一张能看的照片,当时的算法非常简单,主要就是做一些基础的校正,比如把因为镜头不完美造成的图像扭曲给拉直。

(来源:早期手机摄像头技术综述报告)

后来,大家开始追求更高的像素,厂商们开始搞“像素大战”,传感器上的感光点(像素)越来越多,从几十万涨到几百万甚至上千万,这时候,ISP的任务就变重了,它得处理海量的数据,而且还要想办法让高像素照片的噪点别那么多,单纯的ISP已经有点力不从心了,算法开始变得重要,算法要能判断在光线暗的时候,怎么通过降低一点清晰度来让画面更干净,这时候,传感器、ISP和算法开始需要互相配合了。

(来源:关于手机摄像头像素发展的行业分析)

再往后,大家发现光堆像素不行了,照片质量没见得好多少,行业开始转向“计算摄影”,这可以看作是传感器、芯片和算法深度合作的开始,一个标志性的技术是“多帧合成”,算法会指挥摄像头连续快速拍好多张照片,然后ISP和算法一起工作,从每张照片里选出最好的部分(比如这张曝光好,那张细节清楚),最后拼成一张完美的照片,像HDR(高动态范围)效果就是这么做出来的,让亮的地方不过曝,暗的地方有细节。

(来源:各手机厂商关于计算摄影的技术发布会)

为了处理更复杂的计算摄影任务,手机芯片也开始进化,除了专门的ISP,还加入了专门处理AI任务的NPU(神经网络处理器),这时候,算法也变聪明了,变成了AI算法,拍人像虚化背景(虚化算法),以前靠软件识别边缘很生硬,现在AI能更准确地认出人和背景的边界,夜景模式也变得很强,算法能通过AI判断场景,决定用多长的曝光时间和如何降噪,这时候,传感器提供原始数据,强大的ISP和NPU提供算力,AI算法负责智能决策,三者紧密合作。

(来源:芯片厂商如高通、苹果发布的芯片架构白皮书)

最近几年,芯片和算法的结合更深了,有些厂商开始尝试把一些算法直接“烧录”到ISP的硬件里,做成硬化的算法,这样处理速度更快、更省电,传感器本身也在变聪明,比如在传感器层面直接做一些初步的HDR处理,分担后续处理的压力,现在的趋势是,传感器、芯片(ISP/NPU)和算法之间的界限越来越模糊,它们更像是一个协同工作的整体系统,共同目标就是拍出超越硬件本身能力的照片。

(来源:近期手机图像技术前瞻分析文章)

本文由邴合乐于2025-11-02发表在笙亿网络策划,如有疑问,请联系我们。

本文链接:http://shandong.xlisi.cn/wenda/69820.html